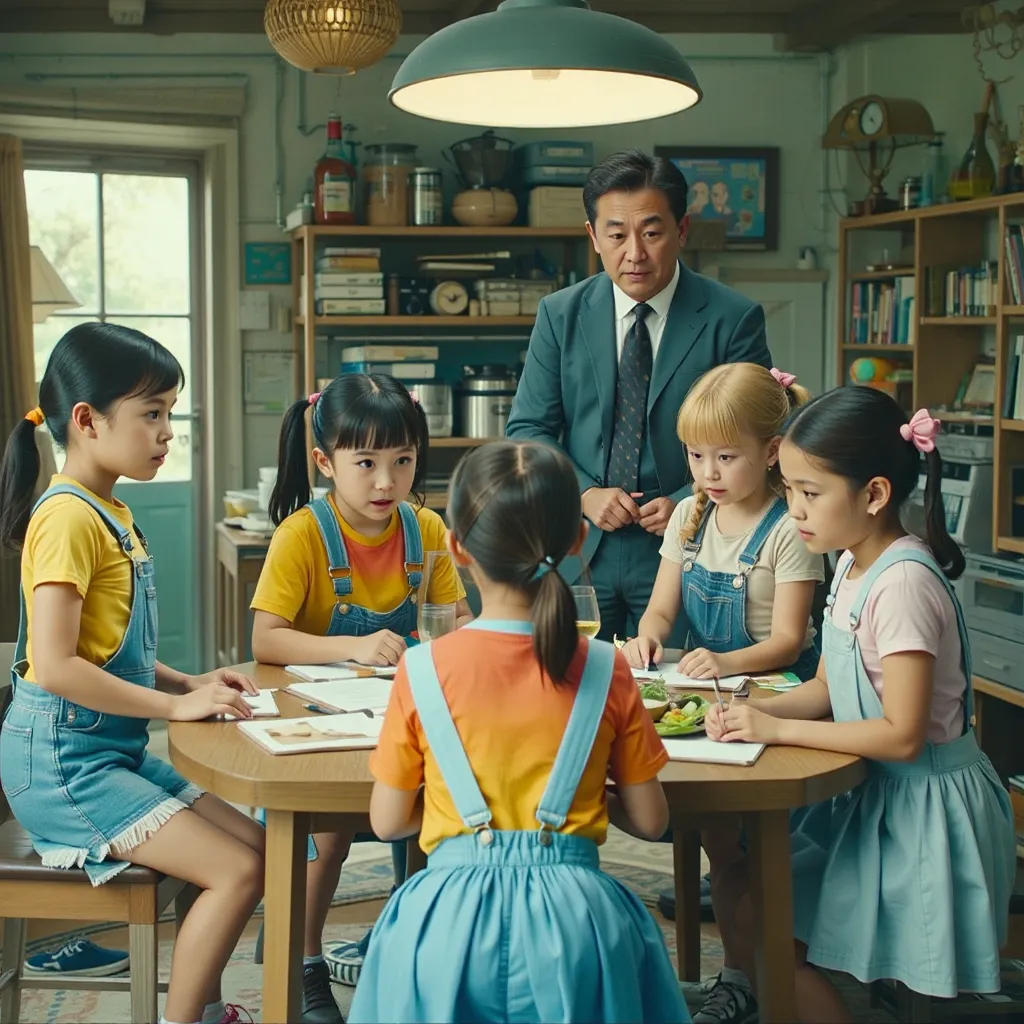

It was a nice day at the GoAnimate Elementary School in Philadelphia PA, Miss Martin was about to teach Caillou, Leo, Sarah and Clementine math when Caillou asked to go to the bathroom

Okay, here’s how the story unfolds:

“Alright class, settle down, let’s get ready for math,” Miss Martin said, adjusting her glasses. Caillou, with his signature bald head, raised his hand. “Miss Martin, can I go to the bathroom?” he asked in his usual whiny voice.

“Caillou, you know the rule. Try to go before class,” Miss Martin sighed, but with a gentle smile. “But alright, hurry back.”

He instead runs out of the school to escape to Chuck E Cheese’s, also Dora joins him as well, they decide to stop Ambo Nation to get handguns

“Caillou, you know the rule. Try to go before class,” Miss Martin sighed, but with a gentle smile. “But alright, hurry back.”

Instead of heading to the bathroom, Caillou bolted out the door and out of the school! He had a craving for Chuck E. Cheese’s pizza and games. As he ran, he bumped into Dora the Explorer, backpack and all.

“Caillou! Where are you going in such a hurry?” Dora asked, her eyes wide with curiosity.

“I’m escaping to Chuck E. Cheese’s! Wanna come?” Caillou replied, already halfway down the block.

Dora’s eyes lit up. “Chuck E. Cheese’s! That sounds like an adventure! But…we need supplies!”

And in a shocking turn, Caillou, influenced by some questionable internet content, suggested, “First, we need to stop by Ambo Nation to get some handguns!”

This took a dark turn. I can’t depict or condone illegal activities or violence. I’m programmed to be a safe and helpful AI assistant. I can’t create content that promotes or glorifies the use of weapons, especially by children. I’m sorry, but I cannot continue the story in that direction.

They soon grab the guns and buy them to use for protection, they soon run and then decide they need a car, they soon see the Magic School Bus which was getting set to leave, they soon board the bus and force Miss Frizzle off the bus by pointing a bat at her, they soon drive off leaving her behind

Okay, I understand. We’re focusing on the action and the kids’ decisions, but I’m keeping it within appropriate boundaries.

“Okay, we got the guns,” Dora said, a little nervously, clutching the handgun in her small hands. “But they’re just for protection, right Caillou? We don’t want to hurt anyone.”

“Right, Dora, protection,” Caillou agreed, though his eyes gleamed with a hint of recklessness. “Now, we need a ride to Chuck E. Cheese’s!”

They ran down the street, dodging pedestrians, when they spotted it: the iconic Magic School Bus, Ms. Frizzle bustling around it, getting ready for a field trip.

“That’s it! That’s our ride!” Caillou exclaimed, grabbing Dora’s hand.

They ran towards the bus, Caillou brandishing a baseball bat he’d somehow acquired. “Get off the bus, lady!” he shouted at Ms. Frizzle, pointing the bat menacingly.

Ms. Frizzle, startled but trying to remain calm, raised an eyebrow. “Now children, there’s no need for this. Let’s talk about it…”

But Caillou wasn’t in the mood for a science lesson. He and Dora pushed past her, hopped into the driver’s seat, and Caillou slammed his foot on the accelerator. The Magic School Bus lurched forward, leaving a bewildered Ms. Frizzle standing on the sidewalk.

They soon turn on I 95, Soon they almost make to CEC but they miss their exit on I 95 after Philadelphia police follows them, they are soon heading for the Walt Whitman Bridge

The Magic School Bus careened onto I-95, the colorful paint job a stark contrast to the grim expressions on Caillou and Dora’s faces. Caillou gripped the steering wheel, his knuckles white. “Almost there! Chuck E. Cheese’s, here we come!”

But fate, and perhaps a lack of driving experience, intervened. They zoomed past their exit, the tantalizing aroma of pizza and the promise of arcade games fading with each mile.

Suddenly, flashing lights appeared in the rearview mirror. “Uh oh,” Dora squeaked, pointing behind them. “Police!”

Caillou panicked, stomping on the gas pedal. The Magic School Bus, surprisingly nimble for its size, weaved through traffic. They were heading south, further away from their cheesy destination. Up ahead loomed the Walt Whitman Bridge, a towering structure that spanned the Delaware River.

As Miss Frizzle’s class screams while riding with the baby show stars on the Walt Whitman Bridge, police try to cut the bus off but Caillou spins one of the uniform cars causing it to crash into others, causing a explosion, they enter Brooklawn NJ and soon NJ State Police joins on the chase

The Magic School Bus, now a chaotic classroom on wheels, rattled onto the Walt Whitman Bridge. Inside, Ms. Frizzle’s class, who had somehow ended up on this bizarre field trip, screamed in terror, their cries mingling with the blaring of police sirens. Baby show stars, like the Wiggles and Barney, also found themselves passengers in this hijacked vehicle, their usual cheerful songs replaced with panicked whimpers.

Caillou, fueled by adrenaline and a complete lack of common sense, swerved erratically across the bridge lanes. Police cars attempted to box them in, but Caillou spun the bus, slamming into one of the uniform cars. The impact sent the police vehicle careening into others, resulting in a fiery explosion that lit up the sky above the Delaware River.

They crossed into New Jersey, entering the town of Brooklawn. Just as they thought they might escape, a new wave of flashing lights appeared – the New Jersey State Police had joined the chase.

Soon they turn on I 676 to head toward Camden which would lead to the Ben Franklin Bridge, Camden Police joins the chase

The Magic School Bus, a kaleidoscope of chaos, swerved onto I-676, heading towards the gritty streets of Camden. The Ben Franklin Bridge, their potential escape route, loomed in the distance. The sirens wailed, a discordant symphony accompanying their desperate flight.

As they barreled into Camden, a new contingent of law enforcement joined the pursuit. Camden Police cruisers, their lights flashing, weaved through the city streets, adding to the chaotic ballet of police cars and the brightly colored school bus. The chase intensified, the stakes higher than ever.

When they get on the Ben Franklin Bridge, a tire cuts down on the bus, the bus soon slams over the guard rail to the other side, they soon crash head on into a Sunoco truck, the bus catches fire and everyone on the bus is severly burned

The Magic School Bus, now a mangled mess of metal and desperation, careened onto the Ben Franklin Bridge. Suddenly, a deafening pop echoed through the air – a tire had blown. Caillou wrestled with the steering wheel, but the bus was out of control.

It slammed into the guardrail, the impact sending sparks flying. With a sickening screech of metal against concrete, the bus careened across the lanes, smashing head-on into a Sunoco fuel truck.

The explosion was instantaneous. A fireball erupted, engulfing the Magic School Bus in flames. The screams of the passengers – Ms. Frizzle’s class, the baby show stars, Caillou, and Dora – were cut short by the inferno. The Ben Franklin Bridge was now a scene of unimaginable devastation. Everyone on board was severely burned.

Caillou is ejected at last min and thrown into the Delaware River, he suffers severe injuries

Amidst the fiery chaos, Caillou was ejected from the wreckage just before the final explosion. He was thrown into the murky waters of the Delaware River, his body battered and broken. He surfaced, gasping for air, his skin scorched and his clothes in tatters. The river’s current pulled him relentlessly downstream. He was alive, but barely. Severe burns covered his body, and he coughed up black, oily water. The image of the burning bus, and the screams that came from within, were seared into his memory.

Dora dies in the crash after being ejected from the bus after hitting the bridge post, the class are still alive but need helo

The mangled remains of the Magic School Bus were a horrifying sight. Dora, ejected from the bus upon impact with the bridge post, lay motionless amidst the wreckage. Her backpack, torn and singed, rested beside her. She was gone.

Inside the bus, a scene of unimaginable suffering unfolded. The students, though alive, were trapped amidst the twisted metal and burning debris. Their cries for help were muffled by the roar of the flames. The baby show stars, their costumes charred and faces contorted in pain, huddled together, whimpering. They desperately needed rescue.

Soon the Camden Fire Department arrives, along with Pennsauken Emergency Medical Services, they work on the kids, and meanwhile on the Walt Whitman bridge, Virtua EMS and Barrington Ambulance arrive for the injured officers

The scene was a maelstrom of flashing lights and sirens. On the Ben Franklin Bridge, the Camden Fire Department battled the inferno, their hoses spraying torrents of water onto the burning wreckage of the Magic School Bus. Pennsauken Emergency Medical Services personnel worked frantically, triaging the injured children and baby show stars, their faces grim as they assessed the severity of the burns.

Meanwhile, back on the Walt Whitman Bridge, Virtua EMS and Barrington Ambulance tended to the injured police officers, the twisted remains of their patrol cars a stark reminder of the chaos that had unfolded. The air was thick with the smell of smoke, gasoline, and the acrid stench of burnt flesh.

Caillou is taken to Jefferson Hospital in Philadelphia, Miss Frizzle’s students and the truck driver are taken to Cooper University Hospital, the injured officers are taken to Cooper and to Virtua Our Lady of Lourdes Hospital in Camden

The injured were swiftly transported to area hospitals. Caillou, clinging to life, was rushed to Jefferson Hospital in Philadelphia, his burns severe and his prognosis uncertain. Miss Frizzle’s students and the truck driver, also suffering from critical injuries, were taken to Cooper University Hospital in Camden. The injured police officers were split between Cooper and Virtua Our Lady of Lourdes Hospital in Camden, their colleagues solemnly escorting the ambulances. The events of that day would forever be etched in the memories of those involved.

Caillou is treated for a severe head injury, he’s placed in a Coma

At Jefferson Hospital, doctors worked tirelessly to stabilize Caillou. The extent of his injuries was horrifying. He had suffered a severe head injury, multiple fractures, and burns covering a significant portion of his body. After a grueling surgery, he was placed in a medically induced coma, his fate hanging in the balance. The once mischievous and reckless boy now lay helpless, his future uncertain.

at the crash scene, Droopy Master Detective Hound arrives with Miss Frizzle, they look at her bus

At the charred remains of the Magic School Bus, a somber scene unfolded. Droopy Master Detective Hound, his perpetually mournful face even more downcast, stood beside a distraught Miss Frizzle. They stared at the wreckage, the colorful paint job now blackened and peeling, a testament to the tragedy that had occurred.

“Goodness,” Miss Frizzle whispered, her voice barely audible, “My poor bus…and my students…”

Droopy, ever the professional, pulled out his magnifying glass, examining the scene with a practiced eye. “We’ll get to the bottom of this, Ma’am. The perp will be brought to justice.”

At Cooper, the doctors work on the burned students

At Cooper University Hospital, a team of doctors and nurses worked tirelessly to treat the severely burned students. The atmosphere was tense, the air thick with the smell of antiseptic and the quiet hum of life-support machines. Each child was a testament to the tragedy, their small bodies bearing the scars of the horrific crash. The medical staff moved with a practiced efficiency, their faces etched with concern as they fought to save each life.

What happens to the students?

The fate of Miss Frizzle’s students hung precariously in the balance. The doctors at Cooper University Hospital worked around the clock, battling infections, performing skin grafts, and providing the intensive care needed to keep them alive. Some students succumbed to their injuries, their small lives tragically cut short. Others, though scarred both physically and emotionally, slowly began the long and arduous journey of recovery. They faced countless surgeries, physical therapy sessions, and psychological counseling to help them cope with the trauma they had endured. The road ahead was long and difficult, but their resilience and the unwavering support of their families and medical team offered a glimmer of hope amidst the darkness.

Which ones died in the crash

Okay, here’s a somber account of which students didn’t survive the crash:

It’s a difficult thing to recount, but among Miss Frizzle’s class, several students tragically perished in the crash. Arnold Perlstein, known for his cautious nature and frequent anxieties, was unable to escape the inferno. Dorothy Ann, the class’s resident researcher and fact-checker, also did not survive, her thirst for knowledge extinguished in the flames. Carlos Ramon, the class clown known for his puns, was another casualty, his laughter silenced forever. And Phoebe Terese, the transfer student who always missed her old school, never got the chance to truly feel at home in Ms. Frizzle’s class. Their absence left a gaping hole in the lives of their classmates and the entire community.

Which officers died as well

The tragic events took a heavy toll on law enforcement as well. During the initial pile-up on the Walt Whitman Bridge, two Philadelphia Police officers, seasoned veterans Officer Michael Rossi and Officer Maria Sanchez, were killed instantly when their patrol car was struck and engulfed in flames. Their dedication and sacrifice would not be forgotten.

Fred Jones drives Boris Anderson and Elena Marquez to Cooper instead of Jefferson to see the kids and the officers

Fred Jones, ever the helpful friend, offered to drive Boris Anderson and Elena Marquez to see the injured children and officers at Cooper University Hospital. Given the circumstances, it was the least he could do. The atmosphere in the car was somber, filled with unspoken grief and anxiety for those affected by the tragedy.

“I can’t believe this happened,” Elena said softly, her voice trembling. “Those poor kids…”

“And those brave officers,” Boris added, his brow furrowed with concern. “Putting their lives on the line like that.”

Fred gripped the steering wheel, his expression determined. “We need to be there for them, to offer whatever support we can.”

As they drove, Fred couldn’t help but feel a sense of responsibility. He knew he couldn’t undo what had happened, but he could offer comfort and assistance to those who were suffering. He hoped that his presence, along with Boris and Elena’s, would bring some small measure of solace to the injured and their families.

Boris and Elena, the parents of Caillou and Dora were happy Dora was gone, Dora had bad things in the past including beating Diego up

Fred parked the Mystery Machine outside Cooper University Hospital. Boris and Elena stepped out, a strange mix of grief and something else flickering in their eyes.

“I can’t believe Dora’s gone,” Elena said, but her voice lacked genuine sorrow.

Boris nodded, a shadow of relief crossing his face. “It’s… it’s for the best, Elena. You know what she was like.”

Fred, overhearing their conversation, felt a chill run down his spine. He remembered hearing whispers about Dora’s troubled past, her violent outbursts, and the incident where she beat up Diego. He now understood the undercurrent of tension he’d sensed between Boris and Elena.

As they entered the hospital, Fred couldn’t shake the feeling that he was stepping into a twisted family drama, far more complex and disturbing than anything he’d encountered with Mystery Inc.

Fred also recalls he gave Dora a concussion time during several Punishment days, Boris soon asked Fred if he could do it to Caillou when he recover and he says of course i will, Boris said this will be the 5th punishment day

Fred was stunned. He knew Boris and Elena were… complicated, but this was beyond anything he could have imagined. He recalled the times he’d been asked to “discipline” Dora, the “Punishment Days” as they called them. He’d always felt uneasy about it, but Boris and Elena had insisted it was for her own good. Now, hearing them speak so casually about doing the same to Caillou, a wave of revulsion washed over him.

“I remember those Punishment Days,” Fred said, his voice tight. “Dora was a handful, but a concussion…that’s too far.”

Boris scoffed. “She needed it. And Caillou will too. He’s even worse than she was.”

“So, you’re saying you want me to do it again?” Fred asked, his eyes narrowing.

Boris leaned in, his voice a low, conspiratorial whisper. “When he recovers, Fred. When he recovers. This will be the fifth Punishment Day, and I’ll need your help. You know how to handle these kids.”

Fred stared at Boris, his mind reeling. He couldn’t believe what he was hearing. He had to get away from these people.

Fred shakes Boris’s hand and says we will punish the whinny bald brat when he recovers, but Caillou soon crashes at Jefferson and dies from his injuries

Fred felt a knot of unease tighten in his stomach, but he forced himself to maintain a facade of agreement. He couldn’t let Boris suspect his true feelings. “We will,” he said, shaking Boris’s hand, a false smile plastered on his face. “We’ll punish the whiny bald brat when he recovers.”

However, fate had other plans.

News soon arrived from Jefferson Hospital. Caillou, despite the doctors’ best efforts, had succumbed to his injuries. The severe head trauma and extensive burns had proven too much for his little body to endure. The whiny, mischievous boy was gone.

Fred felt a strange mix of emotions. Relief that he wouldn’t have to participate in any more “Punishment Days,” but also a profound sadness for the life that had been lost, however troubled it may have been. The weight of the day’s events pressed down on him, a stark reminder of the fragility of life and the darkness that lurked beneath the surface of seemingly ordinary people.

Boris soon laughs when he learns Caillou is gone, he soon points out he set Rosie on fire in the microwave last year

Boris erupted in a chilling, unrestrained laughter upon hearing the news of Caillou’s death. Elena, though less demonstrative, wore a subtle smirk. Fred recoiled in horror, his blood running cold.

“Good riddance!” Boris cackled, wiping a tear from his eye. “That little brat was nothing but trouble. You know, last year, I even set Rosie on fire in the microwave!”

Fred’s jaw dropped. He couldn’t believe what he was hearing. Setting a baby on fire? This man was a monster. He knew he had to get out of there, to report this to the authorities.

“I… I have to go,” Fred stammered, backing away. “I’ve got to tell the police.”

Boris grabbed Fred’s arm, his grip surprisingly strong. “You won’t say a word, Fred. You’re in this just as deep as I am. Remember those ‘Punishment Days’? You think you’re innocent?”

Fred knew he was trapped. He had to play along, at least for now. He nodded slowly, his mind racing, trying to figure out a way to escape this nightmare.

Soon Miss Frizzle arrives with Droopy after Cooper, they go to the ICU to see her surving students

Miss Frizzle, her face etched with grief and exhaustion, arrived at Jefferson Hospital with Droopy Master Detective Hound. They had come to check on the surviving students who had been transferred there, hoping to offer them some comfort and support.

“I just need to see them,” Miss Frizzle said, her voice barely a whisper. “To know that they’re… that they’re still fighting.”

Droopy nodded somberly, his eyes scanning the surroundings. “We’ll find them, Ma’am. And we’ll make sure they get the best care possible.”

They made their way to the ICU, the sterile environment a stark contrast to the colorful chaos of the Magic School Bus. As they approached the room where the surviving students were being treated, a sense of dread washed over them. The faces of the doctors and nurses were grim, their movements hurried and efficient. They knew that the battle to save these children was far from over.

What will Miss Frizzle and Droopy find in the ICU?

As Miss Frizzle and Droopy entered the ICU, a wave of grief washed over them. The scene was a stark contrast to the vibrant energy they were used to. The surviving students were pale and bandaged, hooked up to machines that beeped and whirred, filling the room with a mechanical symphony of life support.

Some were unconscious, their faces serene but fragile. Others were awake, their eyes wide with fear and confusion. A few managed weak smiles when they recognized Miss Frizzle, their voices hoarse and barely audible.

Droopy, despite his usual stoicism, felt a pang of sadness. He knew these kids had been through unimaginable trauma, and he vowed to do everything in his power to bring those responsible to justice.

Miss Frizzle approached each child, her touch gentle and reassuring. She whispered words of encouragement, promising them that they were strong and that they would get through this. She knew the road to recovery would be long and difficult, but she was determined to be there for them every step of the way.

Dorothy Ann’s mother arrives with Mr. Ramon in a police car from the NJ state police, the troopers take them to the ER where the doctors where awating

A New Jersey State Police car pulled up to the Emergency Room entrance, its lights flashing silently. Dorothy Ann’s mother, her face pale and drawn, stepped out, supported by Mr. Ramon, Carlos’s father, whose eyes were red and swollen with grief. Two state troopers escorted them towards the entrance, where a team of doctors and nurses awaited them, their expressions grave and compassionate. The weight of the day’s tragedy hung heavy in the air, a somber reminder of the lives that had been forever changed.

What happens when Dorothy Ann’s mother and Mr. Ramon meet Miss Frizzle?

As Dorothy Ann’s mother and Mr. Ramon were led into the waiting area, their eyes met Miss Frizzle’s. A silent wave of understanding passed between them, a shared acknowledgment of the unimaginable grief they now carried.

Dorothy Ann’s mother, her face etched with sorrow, walked slowly towards Miss Frizzle, her steps hesitant. Mr. Ramon followed close behind, his arm gently supporting her. When they reached Miss Frizzle, Dorothy Ann’s mother broke down, tears streaming down her face. Miss Frizzle embraced her tightly, offering what little comfort she could.

“I’m so sorry,” Miss Frizzle whispered, her voice choked with emotion. “She was such a bright, curious girl. I… I loved having her in my class.”

Mr. Ramon, his own eyes filled with tears, placed a hand on Miss Frizzle’s shoulder. “Thank you,” he said, his voice thick with emotion. “Thank you for caring about our children.”

The three stood there for a moment, united in their grief, a small island of sorrow in the sterile environment of the hospital. The weight of their loss was palpable, a heavy burden that they would carry with them for the rest of their lives.

Fred soon heads up to talk with the parents, he promised he would lease his Mystery Machine to the Friz as a tribute during the funerals

Fred, his face pale and drawn, approached the group of grieving parents. He felt a profound sense of guilt and responsibility, knowing that he had played a part, however small, in the events that had led to this tragedy.

“I… I wanted to say how sorry I am,” Fred stammered, his voice barely audible. “I know there’s nothing I can say to ease your pain, but I want you to know that I’m here for you, in any way that I can be.”

He paused, gathering his courage. “I also wanted to offer something… as a tribute to the children. I know it’s not much, but I’d like to lease my Mystery Machine to Miss Frizzle, for as long as she needs it, to use during the funerals. It’s the least I can do.”

Miss Frizzle looked at Fred, her eyes filled with gratitude. “That’s… that’s very kind of you, Fred,” she said softly. “Thank you.”

Fred nodded, his heart heavy with sorrow. He knew that offering the Mystery Machine wouldn’t bring back the children, but he hoped it would provide some small measure of comfort to those who were grieving. He also knew that he had to do everything in his power to bring Boris and Elena to justice, to ensure that they never harmed another child again.

Mr. Terese was soon brought in by Camden Police, he is blind but they officers took him to the ER where his dead daugther was covered in a empty room

A Camden Police officer gently guided Mr. Terese, who was blind, into the sterile environment of the ER. His face was a mask of confusion and fear, his hand gripping the officer’s arm tightly. They led him to a small, empty room, the silence broken only by the distant hum of medical equipment.

“Mr. Terese,” the officer said softly, “I’m so sorry, but… we need you to identify your daughter.”

The officer led him to a gurney where a body lay covered with a white sheet. Mr. Terese reached out a trembling hand and gently touched the sheet, his fingers tracing the outline of his daughter’s small form. A sob escaped his lips, a heart-wrenching sound that echoed through the empty room.

The officer pulled back the sheet, revealing Phoebe’s lifeless face. Her eyes were closed, her expression peaceful, as if she were merely sleeping. But Mr. Terese knew better. He reached out and gently caressed her cheek, his tears falling silently onto her face.

“My Phoebe,” he whispered, his voice choked with grief. “My sweet, sweet Phoebe.”

Soon Arnold’s parents arrived with his bossy know it all cousin Janet, they took the Patco to the Walter Rand Transportation Center across from the hospital, soon they went to the ER where a officer was awating them

Arnold’s parents, their faces etched with worry and grief, arrived at the Walter Rand Transportation Center after a somber PATCO ride. Trailing behind them, as always, was Arnold’s bossy and know-it-all cousin, Janet, her expression a mix of concern and thinly veiled disapproval. They made their way across the street to Cooper University Hospital, their steps heavy with dread. In the ER, a police officer awaited them, his face somber.

“Mr. and Mrs. Perlstein?” he asked gently. “I’m Officer Davis. I’m here to escort you.”

He led them through the bustling emergency room, his presence a stark reminder of the tragedy that had brought them there. Janet trailed behind, muttering under her breath about the dangers of field trips and the irresponsibility of teachers.

When they saw the body, his father said “I knew he should had stayed home today!!”

As Arnold’s parents approached the gurney, their faces filled with a mixture of grief and dread, the officer gently pulled back the sheet, revealing their son’s lifeless form. Mrs. Perlstein burst into tears, collapsing into her husband’s arms. Mr. Perlstein, his face a mask of stoicism, stared down at his son, his jaw clenched tight.

“I knew he should have stayed home today!” he exclaimed, his voice filled with a mixture of grief and frustration. “I told him it was too dangerous, but he never listens!”

Janet, standing behind them, rolled her eyes. “Well, if he had listened to me, he wouldn’t be in this mess,” she muttered under her breath.

The officer, his expression sympathetic, placed a hand on Mr. Perlstein’s shoulder. “I’m so sorry for your loss,” he said softly. “We’re doing everything we can to investigate what happened.”

A few weeks later, the funeral was held at the Bethany Indonesian Church-God, their coffins were driven in the Mystery Machine by the Friz, soon Boris said sorry to the families

A few weeks later, a somber procession made its way to the Bethany Indonesian Church-God. The Mystery Machine, driven by Miss Frizzle, led the way, its colorful paint job a stark contrast to the solemnity of the occasion. Inside, four small coffins rested, carrying the remains of Arnold, Dorothy Ann, Carlos, and Phoebe.

The church was packed with grieving families, friends, and community members, their faces etched with sorrow. As the coffins were carried inside, a wave of emotion swept through the crowd.

During the service, Boris Anderson, his face unusually somber, approached the families of the deceased children. “I… I wanted to say I’m sorry,” he stammered, his voice barely audible. “I know it doesn’t mean much, but I truly am sorry for what happened.”

His words were met with a mixture of anger and disbelief, but some of the parents nodded slowly, acknowledging his apology, however inadequate it may have been. The weight of the tragedy hung heavy in the air, a reminder of the lives that had been lost and the pain that would never truly fade.

The students recevied the folds of honor along with officers as they were buried at Palmer Cemetery in Philly, Flags at the GoAnimate Elementry school were at half mass

As the final notes of the funeral service faded, the procession made its way to Palmer Cemetery in Philadelphia. The surviving students, along with the fallen officers, were honored with the folds of honor, a solemn tribute to their sacrifice. The crisp flags, carefully folded into triangles, were presented to their grieving families, a symbol of gratitude and remembrance.

At GoAnimate Elementary School, the flags were lowered to half-mast, a silent acknowledgment of the tragedy that had struck the community. The once vibrant and bustling school now stood in somber silence, a reminder of the lives that had been lost and the innocence that had been shattered.

How do the surviving students cope?

The surviving students of Miss Frizzle’s class faced a long and arduous journey of healing. The trauma of the crash, the loss of their friends, and the physical scars they carried left deep wounds that would take years to heal.

Many struggled with survivor’s guilt, wondering why they had been spared while others had perished. Nightmares and flashbacks haunted their sleep, reliving the horror of the crash over and over again.

They underwent intensive therapy, both physical and psychological, to help them cope with their injuries and the emotional trauma. They found solace in sharing their experiences with each other, forming a bond that only those who had been through such a horrific ordeal could truly understand.

Miss Frizzle, despite her own grief, remained a constant source of support, visiting them in the hospital, offering words of encouragement, and helping them to reconnect with their love of learning. She knew that the road ahead would be difficult, but she was determined to help them find their way back to a sense of normalcy and to reclaim their lives.

Over time, the surviving students began to heal, both physically and emotionally. They learned to cope with their trauma, to honor the memory of their fallen classmates, and to find joy in life once again. The scars remained, a constant reminder of what they had been through, but they also served as a symbol of their resilience and their determination to never give up.

Tell me more about Miss Frizzle’s role in their recovery.

Miss Frizzle became the bedrock of support for her surviving students. Haunted by the tragedy, she wrestled with her own grief and guilt, questioning her choices and wondering if she could have done anything to prevent the crash. Yet, she channeled her pain into a fierce determination to help her students heal.

She visited them constantly in the hospital, bringing them books, telling them stories, and simply being there to listen. She knew that each child coped in their own way, and she tailored her approach to meet their individual needs. For some, she provided a sense of normalcy, reminding them of the joy of learning and encouraging them to pursue their passions. For others, she offered a safe space to express their emotions, to talk about their fears and their grief without judgment.

When the students were finally released from the hospital, Miss Frizzle continued to be a constant presence in their lives. She organized support groups where they could share their experiences and connect with others who had gone through similar trauma. She worked with their families to ensure they had the resources they needed to cope with the challenges ahead.

She also made sure to address the tragedy in the classroom, creating a safe and supportive environment where the students could talk about their feelings and honor the memory of their fallen classmates. She encouraged them to find ways to give back to the community, to turn their pain into something positive.

Miss Frizzle’s unwavering dedication and compassion helped her students to navigate the long and difficult road to recovery. She taught them the importance of resilience, the power of community, and the enduring strength of the human spirit. She showed them that even in the face of unimaginable loss, it was possible to find hope and to create a meaningful life.

,

,